Repertorio delle ricerche qualitative sulle biblioteche italiane

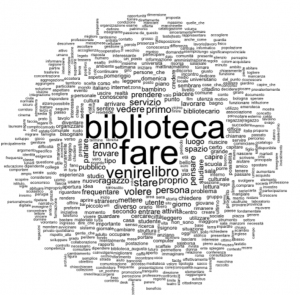

Intorno al 2015 Anna Galluzzi e Chiara Faggiolani hanno avviato una ricognizione delle indagini qualitative svolte dalle e sulle biblioteche pubbliche italiane, a partire dal presupposto che questa metodologia abbia progressivamente preso piede anche nel nostro paese e che, oltre ad aver prodotto interessanti risultati, abbia generato una importante quantità di dati. Si tratta di dati – come noto – di tipo testuale.

Dopo una prima ricognizione che ha portato a raccogliere i testi prodotti nell’ambito di 8 indagini, è stato costruito un primo corpus testuale, su cui è stata effettuata un’analisi mediante l’applicazione delle tecniche dell’analisi automatica del testo (AAT).

Successivamente, si sono aggiunte altre 4 indagini che hanno prodotto un importante ampliamento del corpus testuale e hanno consentito analisi più sofisticate. Nel mese di dicembre 2019 è stata inserita una nuova indagine e si prevedono prossimamente ulteriori integrazioni. Per avere un quadro sempre aggiornato dello stato dell’arte, si veda la pagina “Le indagini censite“.

A questo punto si è ritenuto opportuno trasformare quella che era nata come una ricerca contingente in uno repertorio permanente delle indagini qualitative condotte dalle e sulle biblioteche italiane, creando uno spazio pensato come un punto di riferimento per i bibliotecari italiani in questo ambito. Non è possibile però mettere a disposizione pubblicamente i “dati grezzi”, ossia il corpus, per motivi di privacy ed etica della ricerca: le biblioteche che hanno fornito i testi prodotti nell’ambito delle loro ricerche hanno infatti dato l’autorizzazione a pubblicare solo i risultati delle analisi sul corpus, dove l’annullamento del contesto di riferimento consente di garantire e tutelare la privacy degli intervistati.

L’Associazione Italiana Biblioteche ha condiviso le finalità di questa iniziativa e ha messo a disposizione questo spazio all’interno del suo sito, a cura dell’Osservatorio sulle biblioteche italiane, naturale collocazione per contenuti di questo tipo.

Si è così anche scelto di ampliare il focus che inizialmente riguardava le sole biblioteche pubbliche estendendo la possibilità di collaborare a questo progetto alle biblioteche di qualunque tipologia al fine di costruire “un grande vocabolario” delle biblioteche italiane.

Il Repertorio delle ricerche qualitative sulle biblioteche italiane è articolato nelle seguenti pagine:

- Il progetto e la sua metodologia: breve introduzione al progetto e descrizione della metodologia applicata;

- Le indagini censite: elenco di tutte le indagini qualitative i cui testi sono stati acquisiti nel progetto, dando conto delle nuove acquisizioni nel tempo. Per ogni indagine è indicata la biblioteca oggetto d’indagine, il tipo e la numerosità dei testi raccolti e i soggetti che l’hanno condotta;

- Il corpus attuale: presentazione sintetica delle dimensioni e della composizione del corpus, che sarà aggiornata man mano che nuove indagini vengono acquisite;

- I risultati della ricerca: in questa pagina sono raccolti interventi, articoli, saggi, presentazioni che danno conto dei risultati della ricerca e che propongono gli esiti dell’elaborazione;

- Invito a partecipare e contatti: qui è spiegato quale contributo biblioteche, bibliotecari e ricercatori possono dare alla crescita e alla stabilizzazione di questo progetto e sono presenti i riferimenti per prendere contatto con le due promotrici dell’iniziativa.